长事务

优化

你可以在 information_schema 库的 innodb_trx 这个表中查询长事务,比如下面这个语句,用于查找持续时间超过 60s 的事务。

select * from information_schema.innodb_trx where TIME_TO_SEC(timediff(now(),trx_started))>60如何避免长事务对业务的影响?

这个问题,我们可以从应用开发端和数据库端来看。

首先,从应用开发端来看:

- 确认是否使用了 set autocommit=0。这个确认工作可以在测试环境中开展,把 MySQL 的 general_log 开起来,然后随便跑一个业务逻辑,通过 general_log 的日志来确认。一般框架如果会设置这个值,也就会提供参数来控制行为,你的目标就是把它改成 1。

- 确认是否有不必要的只读事务。有些框架会习惯不管什么语句先用 begin/commit 框起来。我见过有些是业务并没有这个需要,但是也把好几个 select 语句放到了事务中。这种只读事务可以去掉。

- 业务连接数据库的时候,根据业务本身的预估,通过 SET MAX_EXECUTION_TIME 命令,来控制每个语句执行的最长时间,避免单个语句意外执行太长时间。(为什么会意外?在后续的文章中会提到这类案例)

其次,从数据库端来看:

- 监控 information_schema.Innodb_trx 表,设置长事务阈值,超过就报警/或者 kill;

- Percona 的 pt-kill 这个工具不错,推荐使用;

- 在业务功能测试阶段要求输出所有的 general_log,分析日志行为提前发现问题;

- 如果使用的是 MySQL 5.6 或者更新版本,把 innodb_undo_tablespaces 设置成 2(或更大的值)。如果真的出现大事务导致回滚段过大,这样设置后清理起来更方便。

事务思考题

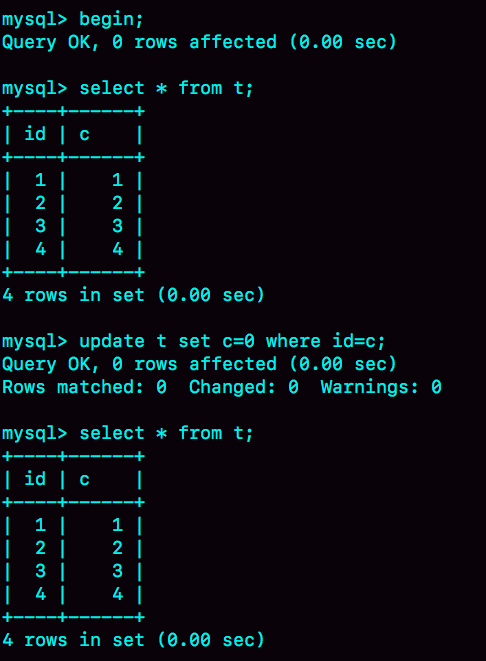

我用下面的表结构和初始化语句作为试验环境,事务隔离级别是可重复读。现在,我要把所有“字段 c 和 id 值相等的行”的 c 值清零,但是却发现了一个“诡异”的、改不掉的情况。请你构造出这种情况,并说明其原理。

mysql> CREATE TABLE `t` (

`id` int(11) NOT NULL,

`c` int(11) DEFAULT NULL,

PRIMARY KEY (`id`)

) ENGINE=InnoDB;

insert into t(id, c) values(1,1),(2,2),(3,3),(4,4);

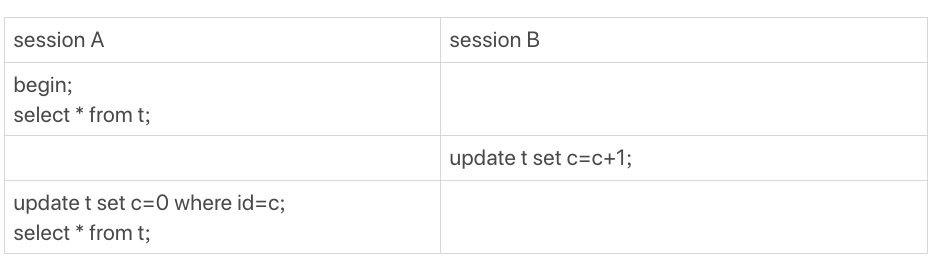

如何构造一个“数据无法修改”的场景。评论区里已经有不少同学给出了正确答案,这里我再描述一下。

这样,session A 看到的就是我截图的效果了。

其实,还有另外一种场景,同学们在留言区都还没有提到。

这个操作序列跑出来,session A 看的内容也是能够复现我截图的效果的。这个 session B’启动的事务比 A 要早,其实是上期我们描述事务版本的可见性规则时留的彩蛋,因为规则里还有一个“活跃事务的判断”,我是准备留到这里再补充的。

业务中如果要绕过这类问题,@约书亚提供了一个“乐观锁”的解法,大家可以去上一篇的留言区看一下。

调试 MySQL

插入 10 万条 27 分钟… 你把 innodb_flush_log_at_trx_commit 和 sync_binlog 都设置成 0 试试

4

什么时候使用 alter table t engine=InnoDB 会让一个表占用的空间反而变大。

在这篇文章的评论区里面,大家都提到了一个点,就是这个表,本身就已经没有空洞的了,比如说刚刚做过一次重建表操作。

在 DDL 期间,如果刚好有外部的 DML 在执行,这期间可能会引入一些新的空洞。

@飞翔提到了一个更深刻的机制,是我们在文章中没说的。在重建表的时候,InnoDB 不会把整张表占满,每个页留了 1/16 给后续的更新用。也就是说,其实重建表之后不是“最”紧凑的。

假如是这么一个过程:

- 将表 t 重建一次;

- 插入一部分数据,但是插入的这些数据,用掉了一部分的预留空间;

- 这种情况下,再重建一次表 t,就可能会出现问题中的现象。

业务设计问题

业务上有这样的需求,A、B 两个用户,如果互相关注,则成为好友。设计上是有两张表,一个是 like 表,一个是 friend 表,like 表有 user_id、liker_id 两个字段,我设置为复合唯一索引即 uk_user_id_liker_id。语句执行逻辑是这样的:

以 A 关注 B 为例:

第一步,先查询对方有没有关注自己(B 有没有关注 A)

select * from like where user_id = B and liker_id = A;

如果有,则成为好友

insert into friend;

没有,则只是单向关注关系

insert into like;

但是如果 A、B 同时关注对方,会出现不会成为好友的情况。因为上面第 1 步,双方都没关注对方。第 1 步即使使用了排他锁也不行,因为记录不存在,行锁无法生效。请问这种情况,在 MySQL 锁层面有没有办法处理?

接下来,我把@ithunter 同学说的表模拟出来,方便我们讨论。

CREATE TABLE `like` (

`id` int(11) NOT NULL AUTO_INCREMENT,

`user_id` int(11) NOT NULL,

`liker_id` int(11) NOT NULL,

PRIMARY KEY (`id`),

UNIQUE KEY `uk_user_id_liker_id` (`user_id`,`liker_id`)

) ENGINE=InnoDB;

CREATE TABLE `friend` (

id` int(11) NOT NULL AUTO_INCREMENT,

`friend_1_id` int(11) NOT NULL,

`firned_2_id` int(11) NOT NULL,

UNIQUE KEY `uk_friend` (`friend_1_id`,`firned_2_id`)

PRIMARY KEY (`id`)

) ENGINE=InnoDB;我把他的疑问翻译一下,在并发场景下,同时有两个人,设置为关注对方,就可能导致无法成功加为朋友关系。

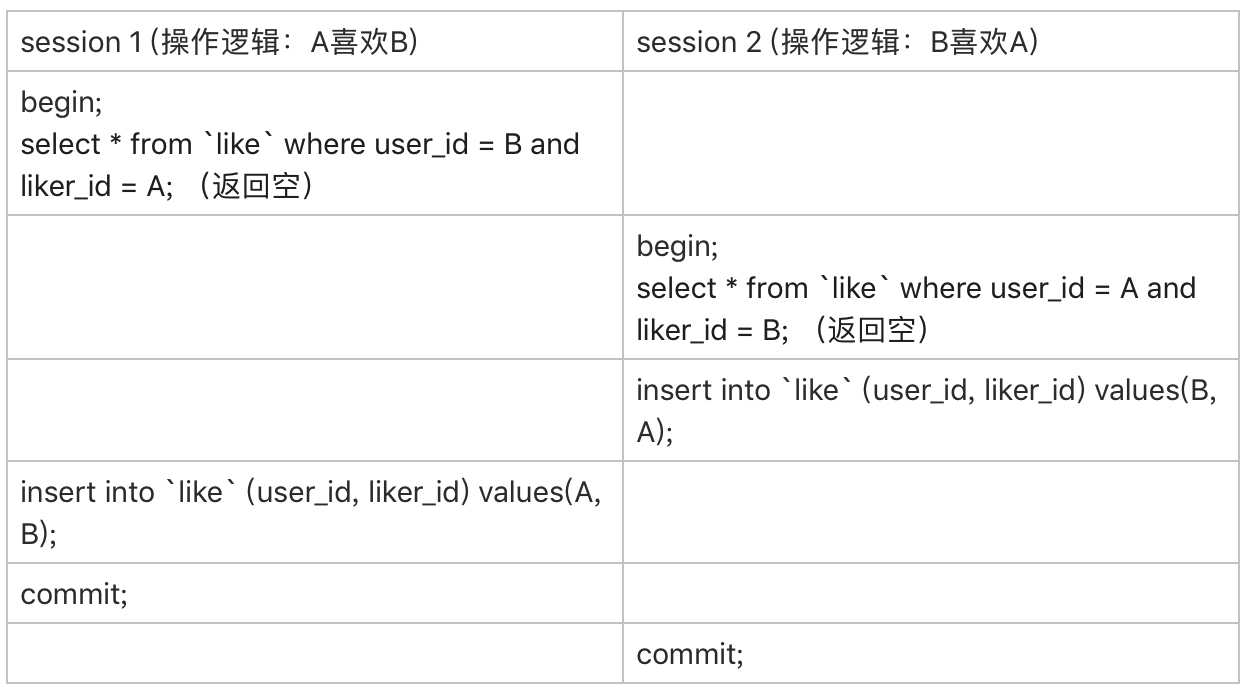

现在,我用你已经熟悉的时刻顺序表的形式,把这两个事务的执行语句列出来:

由于一开始 A 和 B 之间没有关注关系,所以两个事务里面的 select 语句查出来的结果都是空。

因此,session 1 的逻辑就是“既然 B 没有关注 A,那就只插入一个单向关注关系”。session 2 也同样是这个逻辑。

这个结果对业务来说就是 bug 了。因为在业务设定里面,这两个逻辑都执行完成以后,是应该在 friend 表里面插入一行记录的。

如提问里面说的,“第 1 步即使使用了排他锁也不行,因为记录不存在,行锁无法生效”。不过,我想到了另外一个方法,来解决这个问题。

首先,要给“like”表增加一个字段,比如叫作 relation_ship,并设为整型,取值 1、2、3。

值是 1 的时候,表示 user_id 关注 liker_id;

值是 2 的时候,表示 liker_id 关注 user_id;

值是 3 的时候,表示互相关注。

然后,当 A 关注 B 的时候,逻辑改成如下所示的样子:

应用代码里面,比较 A 和 B 的大小,如果 A<B,就执行下面的逻辑

mysql> begin; /*启动事务*/

insert into `like`(user_id, liker_id, relation_ship) values(A, B, 1) on duplicate key update relation_ship=relation_ship | 1;

select relation_ship from `like` where user_id=A and liker_id=B;

/*代码中判断返回的 relation_ship,

如果是 1,事务结束,执行 commit

如果是 3,则执行下面这两个语句:

*/

insert ignore into friend(friend_1_id, friend_2_id) values(A,B);

commit;如果 A>B,则执行下面的逻辑

mysql> begin; /*启动事务*/

insert into `like`(user_id, liker_id, relation_ship) values(B, A, 2) on duplicate key update relation_ship=relation_ship | 2;

select relation_ship from `like` where user_id=B and liker_id=A;

/*代码中判断返回的 relation_ship,

如果是 2,事务结束,执行 commit

如果是 3,则执行下面这两个语句:

*/

insert ignore into friend(friend_1_id, friend_2_id) values(B,A);

commit;这个设计里,让“like”表里的数据保证 user_id < liker_id,这样不论是 A 关注 B,还是 B 关注 A,在操作“like”表的时候,如果反向的关系已经存在,就会出现行锁冲突。

然后,insert … on duplicate 语句,确保了在事务内部,执行了这个 SQL 语句后,就强行占住了这个行锁,之后的 select 判断 relation_ship 这个逻辑时就确保了是在行锁保护下的读操作。

操作符 “|” 是按位或,连同最后一句 insert 语句里的 ignore,是为了保证重复调用时的幂等性。

这样,即使在双方“同时”执行关注操作,最终数据库里的结果,也是 like 表里面有一条关于 A 和 B 的记录,而且 relation_ship 的值是 3,并且 friend 表里面也有了 A 和 B 的这条记录。

不知道你会不会吐槽:之前明明还说尽量不要使用唯一索引,结果这个例子一上来我就创建了两个。这里我要再和你说明一下,之前文章我们讨论的,是在“业务开发保证不会插入重复记录”的情况下,着重要解决性能问题的时候,才建议尽量使用普通索引。

而像这个例子里,按照这个设计,业务根本就是保证“我一定会插入重复数据,数据库一定要要有唯一性约束”,这时就没啥好说的了,唯一索引建起来吧。

MySQL 指令

insert into `like`(user_id, liker_id, relation_ship) values(B, A, 2) on duplicate key update relation_ship=relation_ship | 2;

# 去重指令,如果没有再插入

insert ignore into friend(friend_1_id, friend_2_id) values(B,A);上期问题时间

我们创建了一个简单的表 t,并插入一行,然后对这一行做修改。

mysql> CREATE TABLE `t` (

`id` int(11) NOT NULL primary key auto_increment,

`a` int(11) DEFAULT NULL

) ENGINE=InnoDB;

insert into t values(1,2);这时候,表 t 里有唯一的一行数据(1,2)。假设,我现在要执行:

mysql> update t set a=2 where id=1;你会看到这样的结果:

结果显示,匹配(rows matched)了一行,修改(Changed)了 0 行。

仅从现象上看,MySQL 内部在处理这个命令的时候,可以有以下三种选择:

- 更新都是先读后写的,MySQL 读出数据,发现 a 的值本来就是 2,不更新,直接返回,执行结束;

- MySQL 调用了 InnoDB 引擎提供的“修改为(1,2)”这个接口,但是引擎发现值与原来相同,不更新,直接返回;

- InnoDB 认真执行了“把这个值修改成(1,2)“这个操作,该加锁的加锁,该更新的更新。

你觉得实际情况会是以上哪种呢?你可否用构造实验的方式,来证明你的结论?进一步地,可以思考一下,MySQL 为什么要选择这种策略呢?

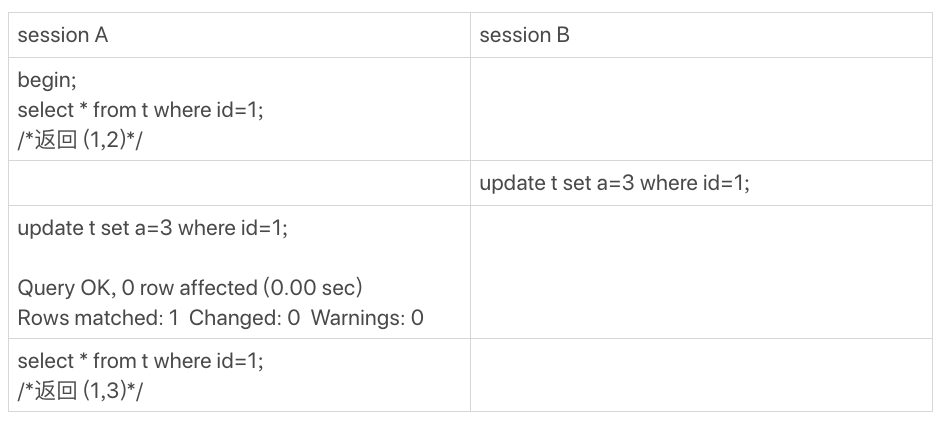

上期的问题是,当 MySQL 去更新一行,但是要修改的值跟原来的值是相同的,这时候 MySQL 会真的去执行一次修改吗?还是看到值相同就直接返回呢?

这是第一次我们课后问题的三个选项都有同学选的,所以我要和你需要详细说明一下。

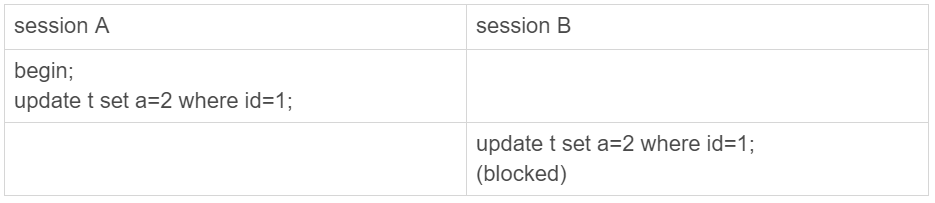

第一个选项是,MySQL 读出数据,发现值与原来相同,不更新,直接返回,执行结束。这里我们可以用一个锁实验来确认。

假设,当前表 t 里的值是(1,2)。

session B 的 update 语句被 blocked 了,加锁这个动作是 InnoDB 才能做的,所以排除选项 1。

第二个选项是,MySQL 调用了 InnoDB 引擎提供的接口,但是引擎发现值与原来相同,不更新,直接返回。有没有这种可能呢?这里我用一个可见性实验来确认。

假设当前表里的值是(1,2)。

session A 的第二个 select 语句是一致性读(快照读),它是不能看见 session B 的更新的。

现在它返回的是(1,3),表示它看见了某个新的版本,这个版本只能是 session A 自己的 update 语句做更新的时候生成。(如果你对这个逻辑有疑惑的话,可以回顾下第 8 篇文章 《事务到底是隔离的还是不隔离的?》 中的相关内容)

所以,我们上期思考题的答案应该是选项 3,即:InnoDB 认真执行了“把这个值修改成(1,2)“这个操作,该加锁的加锁,该更新的更新。

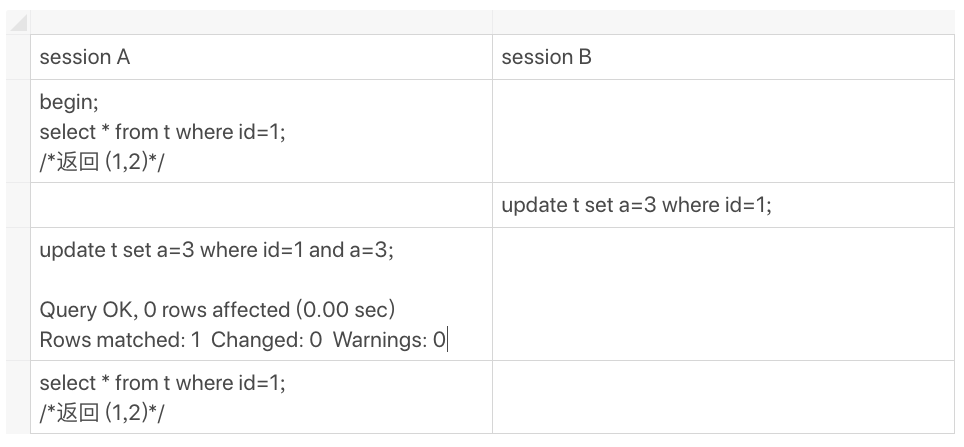

然后你会说,MySQL 怎么这么笨,就不会更新前判断一下值是不是相同吗?如果判断一下,不就不用浪费 InnoDB 操作,多去更新一次了?

其实 MySQL 是确认了的。只是在这个语句里面,MySQL 认为读出来的值,只有一个确定的 (id=1), 而要写的是(a=3),只从这两个信息是看不出来“不需要修改”的。

作为验证,你可以看一下下面这个例子。

补充说明:

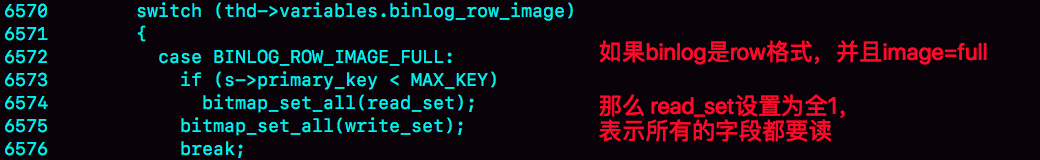

上面我们的验证结果都是在 binlog_format=statement 格式下进行的。

@didiren 补充了一个 case,如果是 binlog_format=row 并且 binlog_row_image=FULL 的时候,由于 MySQL 需要在 binlog 里面记录所有的字段,所以在读数据的时候就会把所有数据都读出来了。

根据上面说的规则,“既然读了数据,就会判断”,因此在这时候,select * from t where id=1,结果就是“返回 (1,2)”。

同理,如果是 binlog_row_image=NOBLOB, 会读出除 blob 外的所有字段,在我们这个例子里,结果还是“返回 (1,2)”。

对应的代码如图 15 所示。这是 MySQL 5.6 版本引入的,在此之前我没有看过。所以,特此说明。

类似的,@mahonebags 同学提到了 timestamp 字段的问题。结论是:如果表中有 timestamp 字段而且设置了自动更新的话,那么更新“别的字段”的时候,MySQL 会读入所有涉及的字段,这样通过判断,就会发现不需要修改。

这两个点我会在后面讲更新性能的文章中再展开。

评论区留言点赞板:

@Gavin 、@melon、@阿建等同学提到了锁验证法;

@郭江伟同学提到了两个点,都非常好,有去实际验证。结论是这样的:

第一,hexdump 看出来没改应该是 WAL 机制生效了,要过一会儿,或者把库 shutdown 看看。

第二,binlog 没写是 MySQL Server 层知道行的值没变,所以故意不写的,这个是在 row 格式下的策略。你可以把 binlog_format 改成 statement 再验证下。

问题

在上一篇文章最后,我留给你的问题是,希望你可以分享一下之前碰到过的、与文章中类似的场景。

@封建的风提到一个有趣的场景,值得一说。我把他的问题重写一下,表结构如下:

mysql> CREATE TABLE `table_a` (

`id` int(11) NOT NULL,

`b` varchar(10) DEFAULT NULL,

PRIMARY KEY (`id`),

KEY `b` (`b`)

) ENGINE=InnoDB;

假设现在表里面,有 100 万行数据,其中有 10 万行数据的 b 的值是’1234567890’,假设现在执行语句是这么写的:

mysql> select * from table_a where b='1234567890abcd';

这时候,MySQL 会怎么执行呢?

最理想的情况是,MySQL 看到字段 b 定义的是 varchar(10),那肯定返回空呀。可惜,MySQL 并没有这么做。

那要不,就是把’1234567890abcd’拿到索引里面去做匹配,肯定也没能够快速判断出索引树 b 上并没有这个值,也很快就能返回空结果。

但实际上,MySQL 也不是这么做的。

这条 SQL 语句的执行很慢,流程是这样的:

- 在传给引擎执行的时候,做了字符截断。因为引擎里面这个行只定义了长度是 10,所以只截了前 10 个字节,就是’1234567890’进去做匹配;

- 这样满足条件的数据有 10 万行;

- 因为是 select *,所以要做 10 万次回表;

- 但是每次回表以后查出整行,到 server 层一判断,b 的值都不是’1234567890abcd’;

- 返回结果是空。

这个例子,是我们文章内容的一个很好的补充。虽然执行过程中可能经过函数操作,但是最终在拿到结果后,server 层还是要做一轮判断的。

funnylog.gitee.io/mysql45/21 讲为什么我只改一行的语句,锁这么多.html

针对特殊锁住的例子进行的解释,算是扩展知识,当遇到枷锁性能问题时候,再看看。

funnylog.gitee.io/mysql45/22 讲 MySQL 有哪些“饮鸩止渴”提高性能的方法.html

业务高峰期,生产环境的 MySQL 压力太大,没法正常响应,需要短期内、临时性地提升一些性能。我以前做业务护航的时候,就偶尔会碰上这种场景。用户的开发负责人说,不管你用什么方案,让业务先跑起来再说。

线上救火经验

@Long 同学,在留言中提到了几个很好的场景。

- 其中第 3 个问题,“如果一个数据库是被客户端的压力打满导致无法响应的,重启数据库是没用的。”,说明他很好地思考了。

这个问题是因为重启之后,业务请求还会再发。而且由于是重启,buffer pool 被清空,可能会导致语句执行得更慢。 - 他提到的第 4 个问题也很典型。有时候一个表上会出现多个单字段索引(而且往往这是因为运维工程师对索引原理不够清晰做的设计),这样就可能出现优化器选择索引合并算法的现象。但实际上,索引合并算法的效率并不好。而通过将其中的一个索引改成联合索引的方法,是一个很好的应对方案。

还有其他几个同学提到的问题场景,也很好,很值得你一看。

@Max 同学提到一个很好的例子:客户端程序的连接器,连接完成后会做一些诸如 show columns 的操作,在短连接模式下这个影响就非常大了。

这个提醒我们,在 review 项目的时候,不止要 review 我们自己业务的代码,也要 review 连接器的行为。一般做法就是在测试环境,把 general_log 打开,用业务行为触发连接,然后通过 general log 分析连接器的行为。

@Manjusaka 同学的留言中,第二点提得非常好:如果你的数据库请求模式直接对应于客户请求,这往往是一个危险的设计。因为客户行为不可控,可能突然因为你们公司的一个运营推广,压力暴增,这样很容易把数据库打挂。

在设计模型里面设计一层,专门负责管理请求和数据库服务资源,对于比较重要和大流量的业务,是一个好的设计方向。

Vincent 同学提了一个好问题,用文中提到的 DDL 方案,会导致 binlog 里面少了这个 DDL 语句,后续影响备份恢复的功能。由于需要另一个知识点(主备同步协议),我放在后面的文章中说明。4

最近才发生了个案列:

由于一个 delete 大事务导致磁盘空间满了,数据库 hang 住,连接不上,所以无法 kill 掉该大事务

当时的观察到的现象是:

binlog 有一个文件已经达到 50 多 G

lsof | grep delete 该 tmp 文件 100 多 G

redo log 还是只有 4 个组,每个文件 1G

undo log 大概有 100 来 G

由于数据库连不上,只有把连接切到从库,kill 掉主库的进程。过了几分钟,binlog 文件才缩小为原来的大小。把主库启起来,但是 recovery 非常慢。后面 kill 掉,又以 innodb_force_recovery=3 恢复,recovery 也是半天没反应。由于这个库也不是重要的库,就把新的主库的备份文件重做了之前的主库,以从库启起来

通过最近的学习+测试分析了下,为什么 binlog 达到了50多 G。tmp 文件100多G.

由于 binlog_cache 不够用,把 binlog 写进了 tmp 文件中,binlog 文件 50 多 G,说明事务已经执行完成,是 binlog 在 fsync 阶段,把空间占满了。fsync 并不是一个 move 而是相当于 copy。要等 binlog 完全落盘以后,才会删除之前的 tmp 文件。redo log 由于是循环写,而且在事务执行过程中,就会把 redo log 分为 mtx 落地到磁盘上。所以没有一次性暴增,还是以 1G 的大小持续写.

我也是后续做测试,观察在事务进行中,redo log 文件一直都有变化。binlog 没有变化

binlog 是在事务执行完以后,才一次性 fsync 到磁盘

但是为什么 recovery=3 的情况下,还比较耗时。我估计是之前脏页较多,而 redo log 又全部被覆盖掉,

需要先通过 binlog 来恢复 redo log,然后再通过 redo log 来恢复数据页。

请问老师有没有更好的办法来处理这种 hang 住的情况?

如果在操作系统层面 kill 掉执行的线程,就好了。

昨天提到的问题 3,我也没有测试出来 Sending to client 这个状态.是之前别人问到的,我也挺懵

2019-01-03 19:56

作者回复

先说明下,binlog 是没有“恢复 redolog”的能力的哈。其它部分分析得很好👍🏿

Binlog 这么大,说明是大事务,崩溃恢复的时候要处理的 redolog 很多,估计耗时间耗在这。

这种磁盘空间满的情况,以前我的处理方法是把最老的 binlog 移动到别的盘(如果确定日志已经备份到备份系统了就删掉),目的是腾出空间让这个事务执行完成。

后面可以考虑这种方案,强制重启还是有点伤的,不过核心还是做好监控,不让出现磁盘 100%写满的情况